Ord och inga visor. Men förvånansvärt lite data. Och det är just data jag fokuserar på i den här slutrepliken. Huruvida min analys är skadlig låter jag vara osagt. Vem som tjänar på faktumet att skolan nu har förbättrats kommenterar jag inte heller. För att förstå sakfrågan måste man anta en konsekvensneutral hållning och söka svaren förutsättningslöst.

I sin text har Henrekson och Wennström selektivt valt ut specifika (i vissa fall felaktiga) data för att påvisa att den svenska skolan inte presterar bra. Detta har bäring för slutsatserna som dras, vilka delvis också baseras på missförstånd om hur internationella prov fungerar och vad de har visat historiskt.

Kunskapsförändringarna i PISA replikeras

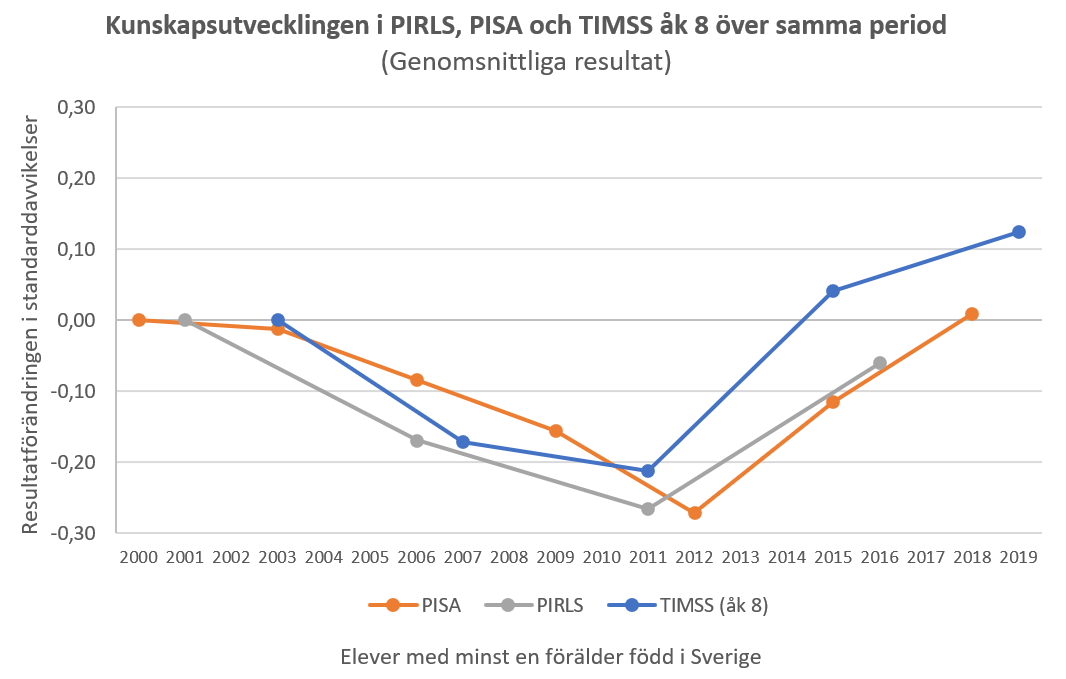

I min analys visar jag först och främst att kunskaperna bland (framför allt) elever med minst en förälder född i Sverige har ökat markant över de senaste tio åren och nu är bättre än, eller tillbaka på samma nivåer som, i början på 2000-talet i alla undersökningar som genomförts i grundskolan sedan dess: PIRLS, PISA och TIMSS.

Men Henrekson och Wennström väljer att enbart kommentera förändringarna i PISA-undersökningen, där fallet i alla tre ämnen har utraderats sedan tidigt 2000-tal bland elever med svensk bakgrund. Eftersom de anser att PISA ”beklagligt nog inte längre [är] jämförbar över tid” ber de oss att ignorera dessa förbättringar.

Det största problemet med detta förhållningssätt är att förändringarna i PISA replikeras i både PIRLS och TIMSS under samma period. I TIMSS 2019 presterade elever med svensk bakgrund bättre än de gjorde 2003, medan de i PISA 2018 alltså har hämtat upp fallet. Förbättringarna i TIMSS och PIRLS sedan 2011 är också väldigt lika dem i PISA sedan 2012.1 Likaså har andelen högpresterande elever utvecklats på ett liknande sätt i alla tre undersökningar under perioden som PISA täcker.

Eftersom Henrekson och Wennström anser att TIMSS ”är mer rättvisande än PISA” är allt detta minst sagt problematiskt för idén att förbättringarna i PISA inte går att lita på. Men de måste ignorera detta för att kunna fortsätta driva tesen att resultatförbättringarna bland elever med svensk bakgrund egentligen inte har inträffat.

Ovanstående är tillräckligt för att motbevisa Henreksons och Wennströms misstänkliggöranden av de resultatförbättringar som jag hänvisar till. Men eftersom de har gett mig ett tillfälle att diskutera frågan tar jag chansen att förklara mer i detalj hur deras PISA-kritik baseras på missförstånd om hur internationella undersökningar allmänt sett fungerar (och har fungerat).

Övergången till dator

Henreksson och Wennström misstänker att övergången till dator är ett problem när man analyserar de svenska resultaten i PISA över tid. Man får anta att de menar att Sveriges uppgång har överdrivits på grund av datorernas inträde. Som jag förklarade i min essä har denna hypotes redan motbevisats. I ett experiment i förstudien till PISA 2015 presterade svenska elever i snitt 4 PISA-poäng sämre på dator än med papper och penna. Om något har övergången till dator alltså sannolikt underdrivit förbättringarna i PISA.

Eftersom Henrekson och Wennström menar att TIMSS ”är mer rättvisande än PISA” är det samtidigt iögonfallande att de verkar ha missat att en majoritet av (men inte alla) deltagande länder gick över till datorbaserade prov i TIMSS 2019. I denna undersökning skrev dock ett mindre slumpmässigt urval elever i ett flertal av dessa länder, däribland Sverige, i stället provet med papper och penna.

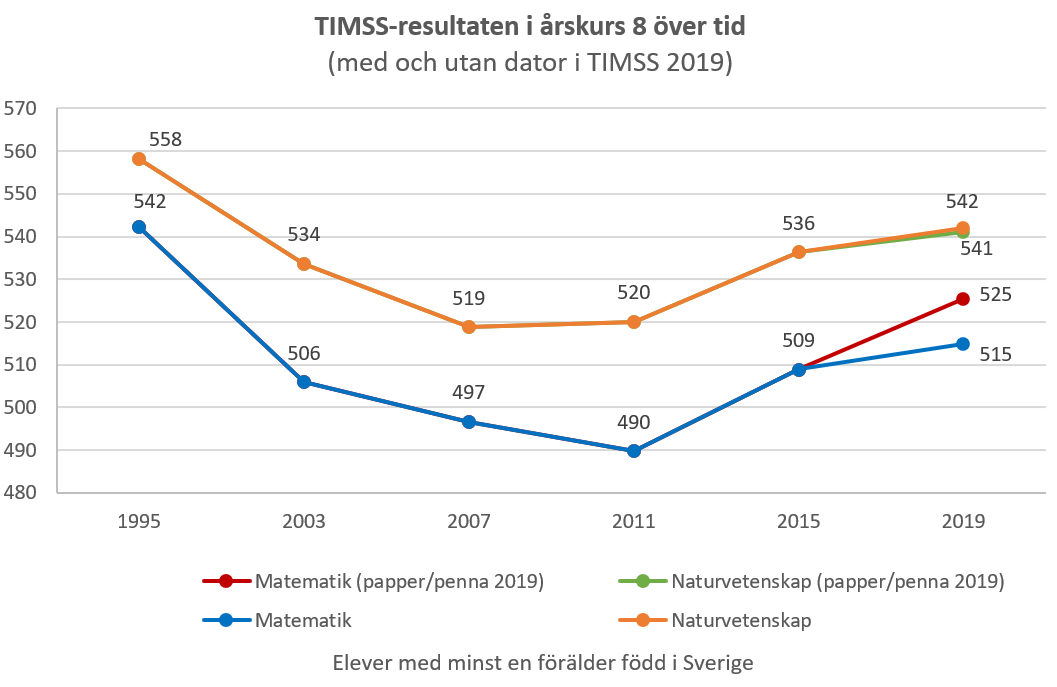

Eftersom jag har tillgång till grunddata för bägge urvalen kan jag nu visa att åttondeklassare med svensk bakgrund skulle ha presterat cirka 11 TIMSS-poäng bättre i matematik, om man baserat resultaten på proven som skrevs med papper och penna. I detta scenario har cirka 70 procent av fallet i matematik sedan TIMSS 1995 hämtats upp: resultaten ökade med hela 36 poäng mellan 2011 och 2019 i denna grupp.

I naturvetenskap är dock resultaten snarlika i urvalet som skrev provet med papper och penna i TIMSS 2019 – och i bägge ämnen i snitt är skillnaden därför inte statistiskt säkerställd. Men om något hade kunskapsförbättringarna bland åttondeklassarna alltså varit ännu större i matematik, om man inte hade gått över till datorbaserade prov i TIMSS.

Henrekson och Wennström nämner även övergången till en adaptiv provdesign i PISA 2018 – i vilken frågornas svårighetsgrad (i viss mån) anpassas efter elevernas svar, vilket bland annat ökar precisionen i resultaten bland låg- och högpresterande elever – som ett skäl att misstro uppgången. Men de tycks ha missat att den adaptiva designen enbart användes i läsförståelse, inte i matematik eller naturvetenskap. Och förbättringarna bland elever med svensk bakgrund i alla tre ämnen var i praktiken lika stora. Fallet har raderats ut i alla tre ämnen. Den adaptiva provdesignen är alltså oväsentlig för de svenska resultatförbättringarna i stort.

Detta är inte konstigt eftersom OECD analyserade frågan i förstudien innan man bestämde sig helt för att använda en adaptiv design. Forskning visar också att den adaptiva designen i läsförståelse mycket riktigt inte tycks ha påverkat resultaten.

Missförstånd kring vad PISA är och har varit

Henrekson och Wennström hänvisar till att Andreas Schleicher, ansvarig för PISA vid OECD, vill förvandla PISA ”från en traditionell utvärdering av förvärvade kunskaper till en utvärdering av förmågor” och att han därför ”kommit ut som en anhängare av en postmodern och socialkonstruktivistisk kunskapssyn”. Huruvida ”denna helomvändning redan har påverkat Pisa på olika subtila sätt går inte att veta”, menar de.

Men OECD har aldrig aspirerat på att provet ska vara ”en traditionell utvärdering av förvärvade kunskaper”. Tvärtom har man sedan starten hävdat att provet inte fokuserar på sådana kunskaper utan i stället på ”unga människors förmåga att använda sina kunskaper och färdigheter för att möta utmaningar i verkligheten” (s. 9), vilket man då förklarade med att många länders läroplaner tenderade att förändras i den riktningen.2

Det finns alltså ingenting som tyder på att resultatförändringarna bland elever med svensk bakgrund har påverkats av förändringar i exkluderingar eller bortfall.

Detta reflekteras bland annat i att frågorna i PISA är textrika och kräver mer läsförståelse, jämfört med TIMSS. Olika länder har också presterat olika i PISA och TIMSS, något som vissa har noterat kan bero på skillnaderna i vad proven mäter. Att elever med svensk bakgrund har förbättrat sina resultat kraftigt i bägge proven sedan runt 2010 är därför positivt, då det visar att uppgången är bred.

Allt detta gör påståendet att ”det inte går att veta” om Schleichers kunskapssyn har påverkat PISA efter 2012 på ”olika subtila sätt” irrelevant. Det har inte skett någon ”helomvändning” som kan förklara någonting. Henrekson och Wennström må anse att förmågorna som mäts i PISA inte är relevanta – men då bör de inte heller använda undersökningen som en måttstock över hur svenska kunskaper försämrades mellan 2000 och 2012.

Frågan om exkluderingar och bortfall i PISA

Vi återkommer så till frågan om exkluderingar av elever från urvalet och bortfall av elever utvalda att delta, vilket Henrekson och Wennström påstår vara ett särskilt ”problem med PISA 2018 i just Sveriges fall”. Diskussionen kring just exkluderingarna har dock handlat om att man plockade bort för många elever med utländsk bakgrund på grund av bristande kunskaper i svenska, ”kanske främst nyanlända”, som Henrekson och Wennström tidigare har uttryckt det.

Tillgängliga data tyder också på att exkluderingarna på grund av bristande erfarenhet av svenska ökade i PISA fram till 2015, medan exkluderingar på grund av olika funktionsnedsättningar inte ökade. Bortfallet kan visserligen ha påverkat resultaten även bland elever med svensk bakgrund, men bortfallet var nästan identiskt i PISA 2000.3

Det finns alltså ingenting som tyder på att resultatförändringarna bland elever med svensk bakgrund har påverkats av förändringar i exkluderingar eller bortfall. Att kunskapsförändringarna replikeras i TIMSS och PIRLS, som beskrivs ovan, är också sannolikt det bästa beviset på att så är fallet. Jag har utöver detta gjort ytterligare analyser över hur bortfall och exkluderingar är relaterade till länders resultatförändringar och dessa tyder på samma sak.

Problemet med exkluderingar och bortfall har dessutom påverkat länder på olika sätt över tid. När Sverige presterade som sämst i PISA 2012 hade man också ett mer representativt urval än de flesta andra OECD-länder. Om Henrekson och Wennström applicerade sin måttstock konsekvent bör de således avfärda Sveriges låga resultat i PISA 2012. Men det gör de inte.

Olika krav på olika undersökningar

Mer generellt existerar exkluderingar och bortfall i alla internationella prov. I TIMSS 2019 exkluderade exempelvis Singapore och Israel 10 respektive 23 procent av urvalet bland åttondeklassare, de två högsta siffrorna bland alla deltagande länder. I Sverige var siffran 6 procent. Bortfallet bland eleverna utvalda att delta var samtidigt 21 procent i USA, 19 procent i Hong Kong och 16 procent i Norge. I Sverige var siffran 9 procent. Även i TIMSS har exkluderingsgraden och bortfallet förändrats olika i olika länder. Om Henrekson och Wennström applicerade sin måttstock konsekvent bör de därför även avfärda TIMSS som opålitligt, vilket de som bekant inte gör.

Detsamma gäller andra undersökningar som Henrekson och Wennström refererar till. Exempelvis har de i andra sammanhang lyft fram hur olika årskullars resultat i PIAAC – ett slags PISA för vuxna (med en adaptiv provdesign) – följer elevers fall i PISA mellan 2000 och 2009. I PIAAC hade Sverige en svarsfrekvens på 45 procent, lägst av alla deltagande länder. Om Henrekson och Wennström applicerade sin måttstock konsekvent bör de därför även avfärda PIAAC som opålitligt, vilket de alltså inte gör.

Men det tycker jag de gör rätt i. För visst kan man använda internationella undersökningar med olika exkluderingsgrad och bortfall över tid och mellan länder. Med olika statistiska efterhandsjusteringar gör man oftast urvalen generellt jämförbara, exempelvis med urvalsvikter. Felmarginaler i resultaten fångar också upp osäkerheter som ofta uppstår. Det perfekta får aldrig bli det godas fiende.

Det man bör undvika är att selektivt attackera vissa prov, eller vissa omgångar i samma prov, om man inte på rigorös basis kan visa att detta är rättfärdigat. Tvärtom är det viktigt att analysera alla undersökningar för att få en rättvis bild av hur svensk skola presterar över tid och i jämförelse med andra länder.

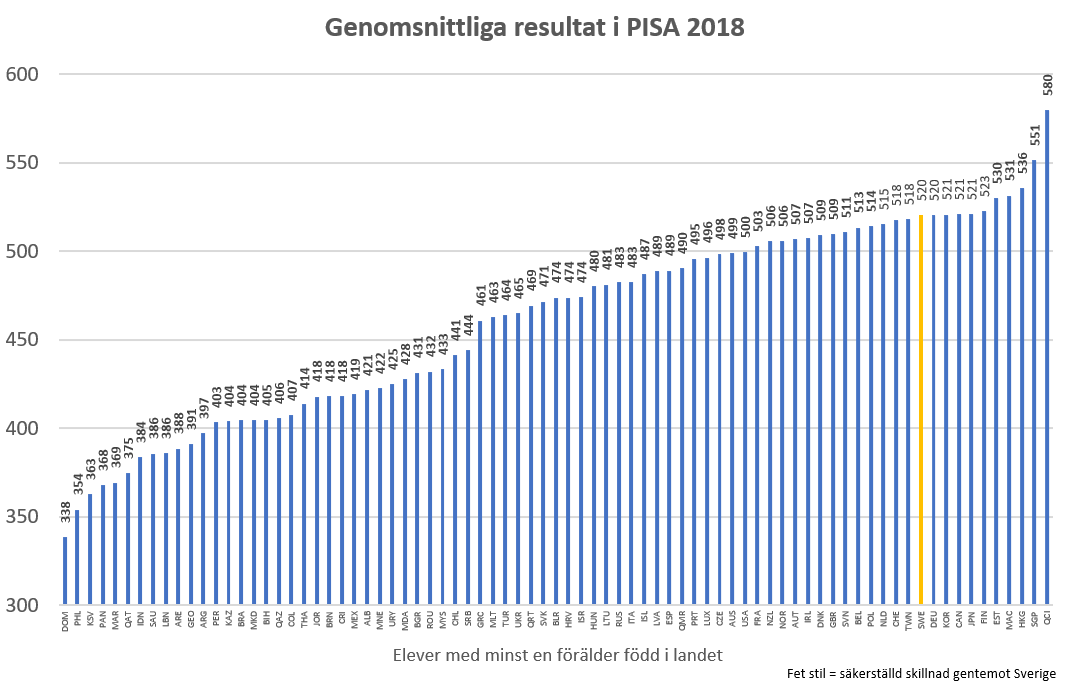

Resultaten i PISA 2018

Detta tar oss till Henreksons och Wennströms analyser av de svenska resultaten i jämförelse med andra länder. Låt oss börja med PISA 2018. Henrekson och Wennström skriver att ”även om vi accepterar…[mitt] påstående att svenskfödda elever idag är bland de bästa i hela OECD” undrar de varför jag inte jämför med toppresterare utanför OECD, specifikt Kina, Macau, Hong Kong, Taiwan och Singapore, speciellt ”eftersom alla utom Singapore är tämligen homogena samhällen”.4 De redovisar därefter dessa länders resultat och menar att Sverige underpresterar jämfört med dem.

Anledningen att jag jämför med OECD-länder – som även inkluderar de östasiatiska toppländerna Japan och Sydkorea – är att de är någorlunda jämförbara och ofta grupperas tillsammans. Man jämför exempelvis frekvent Sveriges resultat med snittet i denna grupp länder.5 Även Henrekson och Wennström lägger mycket fokus på att jämföra med detta snitt i andra sammanhang.

Men visst kan vi jämföra Sverige med andra länder och regioner/städer. Problemet är dock att Henrekson och Wennström inte redovisar resultaten bland elever med inhemsk bakgrund, vilket är nödvändigt om de, för sakens skull, ”accepterar…[mitt] påstående att svenskfödda elever idag är bland de bästa i hela OECD”. De använder alltså fel data.

När man jämför elever med inhemsk bakgrund hamnar Sverige i toppen, på en delad sjätteplats bland deltagande länder – och på samma nivå som Taiwan, Japan6 och Sydkorea. Sverige ligger samtidigt på en delad fjärdeplats när det gäller andelen högpresterande elever och på en delad sjundeplats när det gäller resultaten i den 95:e percentilen.

Man bör här vara medveten om att Kina faktiskt inte deltar i PISA. I stället deltar fyra av Kina utvalda, icke-representativa, regioner/städer, vilka täcker cirka 13 procent av befolkningen – och dessa har bytts ut över tid för att öka resultaten radikalt. Givet Henreksons och Wennströms attacker mot de svenska resultaten litar de förvånansvärt mycket på siffror som i praktiken har manipulerats för att framställa det kinesiska kommunistpartiet i bättre dager.

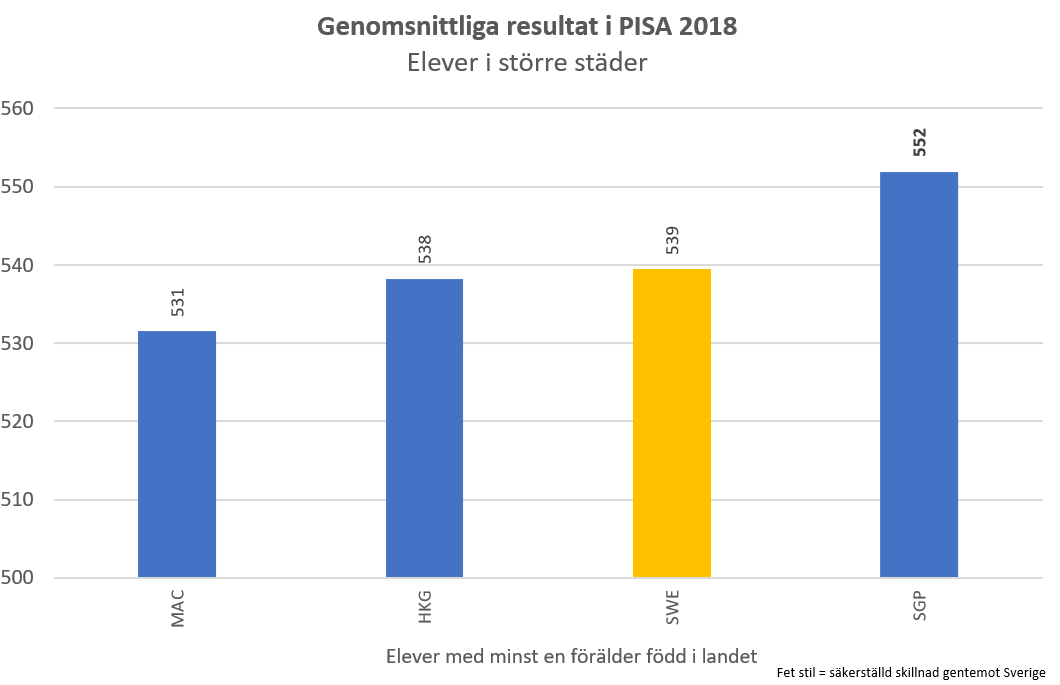

Att jämföra just Hong Kong, Singapore och Macau med Sverige är dock något märkligt, eftersom dessa samhällen består av storstäder. Detta gör också att de inte påverkas av problem som normala länder präglas av, exempelvis svårigheter att locka lärare till landsbygdsskolor. Av flera skäl är det därför rimligast att jämföra elever med inhemsk bakgrund som går i skolan i större städer (100 000 invånare eller fler i PISA:s definition), när man jämför dessa samhällens prestationer med Sveriges.7

Och det visar sig att elever med inhemsk bakgrund i större svenska städer presterar lika bra som motsvarande elever i Hong Kong och Macau – och endast något sämre än motsvarande elever i Singapore. Över lag gäller samma sak om man studerar andelen högpresterande och resultaten i den 95:e percentilen, förutom att Sveriges resultat då är bättre än Macaus med tydlig marginal. Återigen: när man jämför lika med lika mäter sig Sverige med de bästa länderna i PISA.

Sverige har aldrig mätt sig med östasiatiska länder i TIMSS-matematiken

Henrekson och Wennström lägger mycket vikt vid matematikresultaten i TIMSS 2019, som de menar inte är tillräckligt bra – speciellt i relation till östasiatiska länder. Jag håller med. I min essä noterar jag just att TIMSS-matematiken visar att det finns saker att förbättra även bland elever med svensk bakgrund, speciellt då man ligger ganska långt efter de östasiatiska OECD-länderna.

Henrekson och Wennström rapporterar av misstag TIMSS-resultaten i den 95:e percentilen för årskurs 4 i stället för årskurs 8 och inkluderar återigen alla elever i beräkningarna. När man använder korrekta data bland elever med inhemsk bakgrund försvinner flera av skillnaderna med de icke-östasiatiska länder de jämför med och Sverige når en delad 13:e plats. De genomsnittliga kunskapsskillnaderna jämfört med dessa länder är i flera fall till fördel för Sverige, som i detta hänseende når en delad 10:e plats. Man når dock inte de högpresterande östasiatiska samhällena heller i denna kategori.

Men Sverige har aldrig presterat i nivå med dessa samhällen när det gäller TIMSS-matematiken. I de första två undersökningarna 1964 och 1980 var Sverige ett av de sämre länderna och nådde väsentligt lägre resultat än deltagande östasiatiska nationer. Och när Sverige presterade som bäst 1995 var 12 procent av eleverna med inhemsk bakgrund högpresterande i TIMSS-matematiken, att jämföra med motsvarande elever i de östasiatiska toppländerna: Japan på 29 procent,8 Singapore på 39 procent, Sydkorea på 31 procent och Hong Kong på 23 procent. Snittresultaten och eleverna i den 95:e percentilen i Sverige nådde inte heller dessa samhällens prestationer.

Den kunskapsskola som Henrekson och Wennström sörjer har alltså aldrig presterat i den absoluta internationella toppen vad gäller att producera högpresterande elever i TIMSS-matematik – och det vore därför märkligt om vi gjorde detta till måttstocken för att avgöra om den har återuppstått.

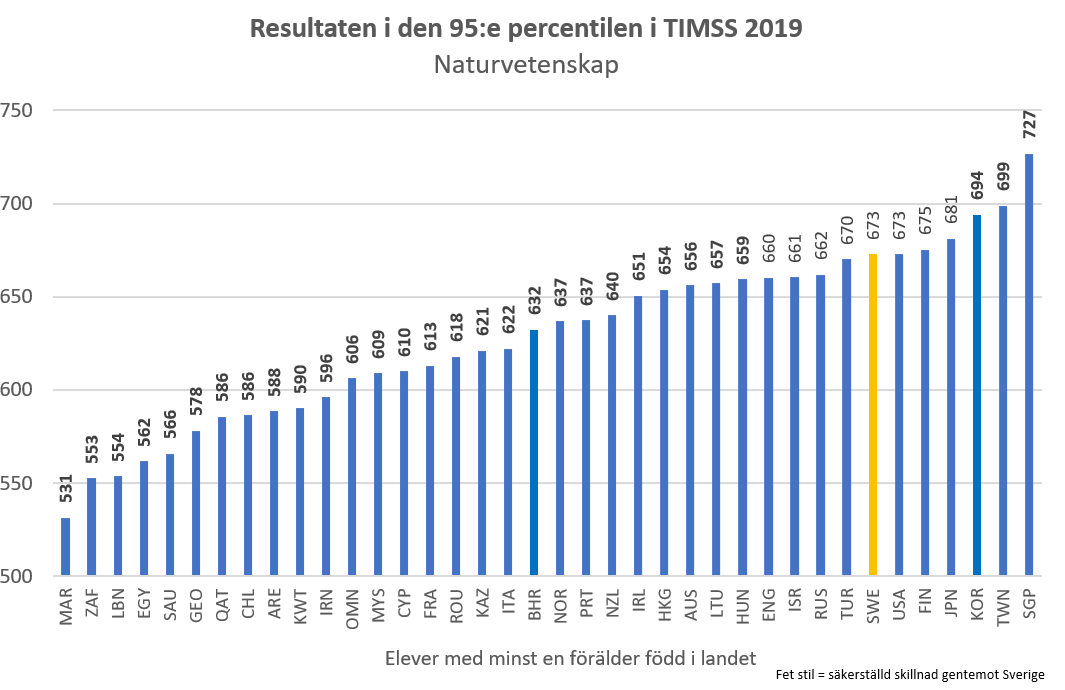

Däremot har andelen högpresterande elever med svensk bakgrund ökat från 1 till 6 procent mellan 2011 och 2019. Andelen var 4 procent år 2003. Samtidigt har resultaten i den 95:e percentilen ökat från 592 till 632 poäng mellan 2011 och 2019. I TIMSS 2003 var siffran 618 poäng. Ännu inte tillräckligt, men definitivt på rätt väg.

När Sverige presterade som bäst i TIMSS 1995 var det i stället i naturvetenskap som resultaten bland de högpresterande stod ut, även jämfört med flera östasiatiska länder. Och som jag visade i min essä sjönk andelen högpresterande elever med svensk bakgrund från 20 till 7 procent mellan 1995 och 2011, men ökade sedan till 16 procent i TIMSS 2019. Man hamnade då på en delad femte plats i detta avseende – och på en delad fjärde plats vad gäller resultaten i den 95:e percentilen, på samma nivå som Japan statistiskt sett och bättre än Hong Kong. Sverige är i detta hänseende nästan tillbaka på samma absoluta nivåer som gällde när kunskapsskolan var som bäst.

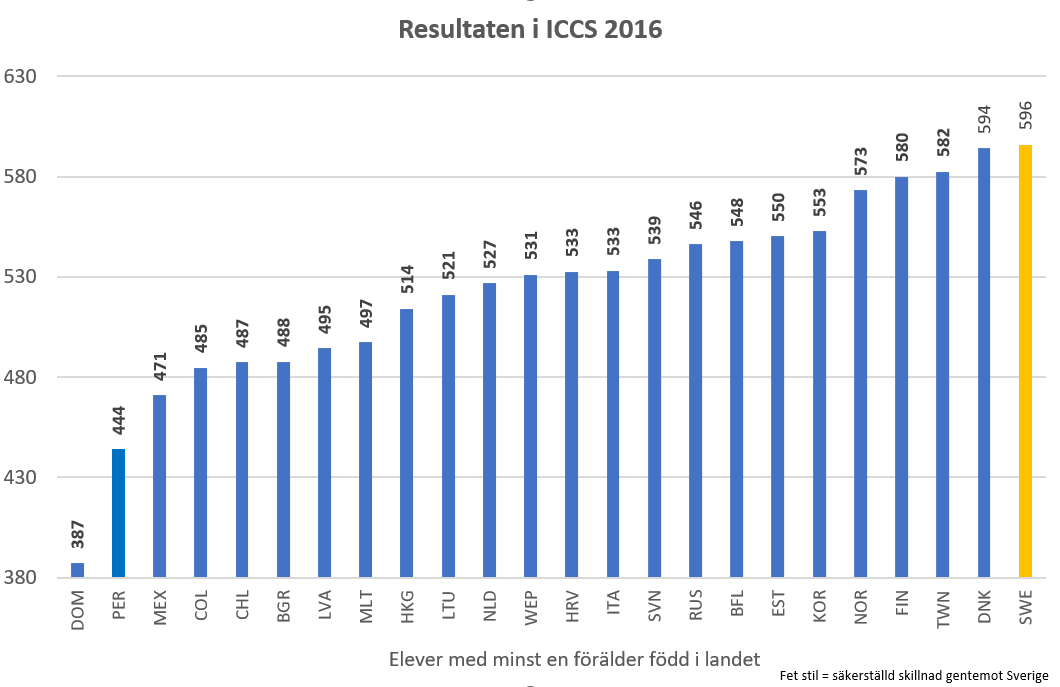

Fel att ignorera samhällskunskap

Henrekson och Wennström väljer samtidigt att ignorera toppresultaten i samhällskunskap i ICCS 2016. Bland elever med inhemsk bakgrund presterar där Sverige bäst av alla länder tillsammans med Danmark – bättre än bland andra Estland, Finland, Sydkorea, Taiwan och Hong Kong.9 I samhällskunskap är elever med svensk bakgrund alltså bättre än motsvarande elever i de östasiatiska samhällen som Henrekson och Wennström lyfter fram. Bilden är i princip identisk om man studerar andelen högpresterande och resultaten i den 95:e percentilen.

Chalmers provresultat fångar inte kunskapsförändringar i grundskolan

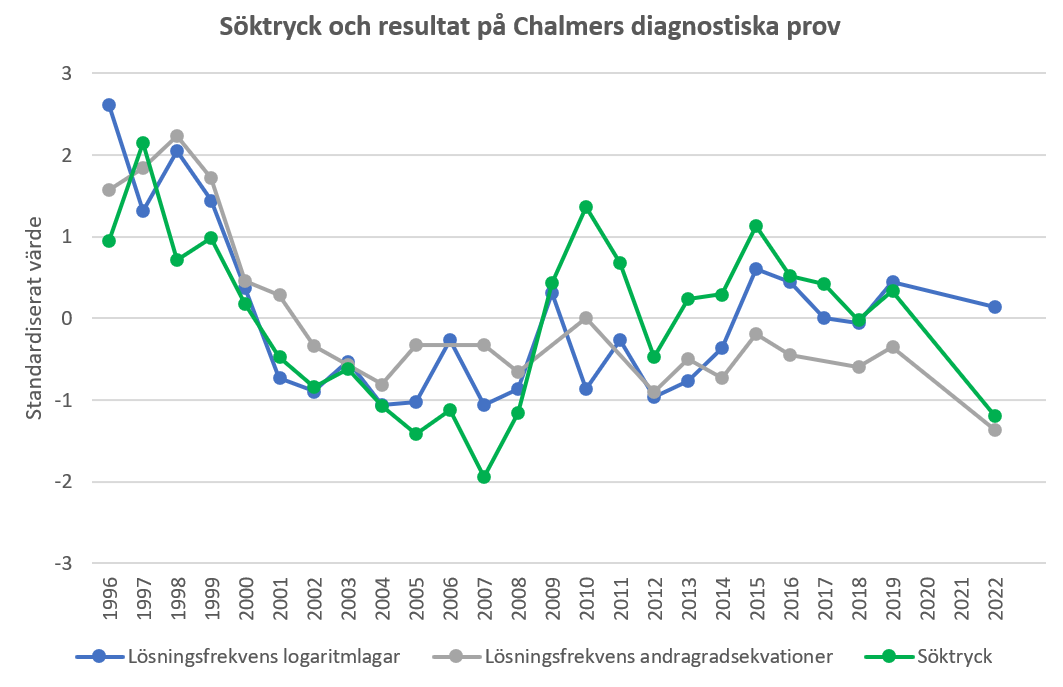

Prestationerna i internationella prov talar alltså sitt tydliga språk. Att resultaten nu har fallit i ett diagnostiskt matematikprov för nybörjare på Chalmers jämfört med året innan pandemin, vilket Henrekson och Wennström till sist noterar, är inte speciellt relevant i sammanhanget. Viktigast är att resultaten sannolikt påverkas av förändringar i intagningen. Förändringar i resultaten på provet – som har diskuterats i debatten om skolan sedan lång tid tillbaka – visar sig mycket riktigt sammanfalla väl med förändringar i söktrycket. Hela fallet i resultat mellan 1996 och mitten på 00-talet tycks exempelvis kunna förklaras av ett sjunkande söktryck. Detsamma gäller försämringen sedan innan pandemin.10

Resultaten på ett liknande prov som skrivs på KTH, vilket också figurerat i debatten om skolan, föll likaså kraftigt mellan 1997 och 2007, men har därefter ökat rejält. Strax innan pandemin låg resultaten på ungefär samma nivåer som runt år 2000. Både nedgången och uppgången i resultat sammanfaller dock extremt väl med söktrycket även på KTH: resultaten föll när söktrycket minskade och ökade när söktrycket ökade.11

Allt detta visar att man bör vara väldigt försiktig med att tolka resultatförändringar på dessa prov som indikatorer på kvalitetsförändringar i grundskolan. De tycks framför allt fånga upp förändringar i intagningen, inte kunskapsförändringar bland elever över lag.

Att acceptera fakta

Det är således dags att acceptera fakta. Resultatförbättringarna är på riktigt och Sverige presterar numera väl i alla tre undersökningar som genomförs i slutet på grundskolan, när man jämför lika med lika.

Som jag noterade i min essä och i det här svaret betyder inte detta att allt är frid och fröjd. Henrekson och Wennström har helt rätt i att de låga resultaten bland elever med utländsk bakgrund är bekymmersamma. Man bör därför definitivt genomföra reformer för att stärka skolan ytterligare. Men man bör akta sig för radikala tilltag utan evidens.

Noter

- Resultatskillnaden mellan PIRLS 2001 och PIRLS 2016 är inte statistiskt säkerställd. Figuren visar förändringarna i resultat från och med den första undersökningen som har genomförts sedan år 2000, vilket är det första året för PISA-undersökningen, uttryckt som andelen i standardavvikelsen i det första provet. I TIMSS och PISA anges de genomsnittliga resultatförändringarna i alla ämnen och standardavvikelsen i den första undersökningen är snittet i alla tre ämnen.

- ”Provet är framåtblickande och fokuserar på unga människors förmåga att använda sina kunskaper och färdigheter för att möta utmaningar i verkligheten, snarare än i vilken utsträckning de behärskar innehållet i en specifik läroplan. Denna inriktning reflekterar en förändring vad gäller läroplaners målsättningar i sig, vilka alltmer handlar om vad elever kan göra med det som de lär sig i skolan och inte bara om huruvida de har lärt sig det” (s. 9) och ”PISA ämnar inte definiera de olika områdena enbart i termer av behärskning av läroplanen, utan i termer av viktiga kunskaper och färdigheter som behövs i vuxenlivet. Bedömningen av ämnesövergripande färdigheter är en väsentlig del av PISA” (s. 8). I den första PISA-rapporten från 2001 menade också Skolverket att ”PISA:s syfte är att undersöka i vilken utsträckning femtonåringar är förberedda för vuxenlivet och rustade att möta framtidens behov” (s. 60).

- Bortfallet var 12 procent i PISA 2000 och 13,5 procent i PISA 2018.

- Hong Kong och Macau hade 60 respektive 37 procent elever med inhemsk bakgrund i PISA 2018 och kan knappast kallas homogena.

- I TIMSS inkluderas även ofta de fåtal EU-länder som inte är medlemmar i OECD i jämförelsegruppen, men dessa presterar alltid sämre än Sverige i snitt när man justerar för olika invandring.

- Eleverna i Japan svarade inte på frågorna om föräldrarnas födelseland i PISA 2018 och jag antar att skillnaden mellan resultaten bland elever med inhemsk bakgrund och alla elever är densamma som i Sydkorea. Eftersom andelen elever som inte har inhemsk bakgrund är extremt liten i Japan (1,8 procent enligt TIMSS 2019) spelar detta i praktiken ingen roll för resultaten.

- I PISA motsvarar detta 60 procent av eleverna med inhemsk bakgrund i Hong Kong och 100 procent av eleverna med inhemsk bakgrund i Macau och Singapore, men 31 procent av eleverna med inhemsk bakgrund i Sverige. Det finns inga data om skolans lokalisering för 25 procent av eleverna med inhemsk bakgrund i Hong Kong, men om man inkluderar dessa i analyserna är resultaten nästan helt identiska.

- Eleverna i Japan svarade inte på frågorna om föräldrarnas födelseland i TIMSS 1995 och jag använder resultaten från alla elever. Eftersom andelen elever som inte har inhemsk bakgrund är extremt liten i Japan (1,8 procent enligt TIMSS 2019) spelar detta i praktiken ingen roll för jämförelsen.

- Hong Kong och Sydkorea mötte inte kravet att bortfallet inte fick vara större än 15 procent bland skolorna som valts ut och 15 procent bland eleverna i dessa skolor (eller 25 procent totalt sett).

- Eftersom delmomenten som inkluderas i provet har varierat kan man inte studera förändringar i snittresultaten över hela perioden som analyseras. Jag fokuserar på resultaten på delmomenten logaritmlagar och andragradsekvationer eftersom det är förändringarna i dessa delmoment som i debatten har redovisats som evidens för att skolans kvalitet har sjunkit över en längre tid. Resultaten är dock väldigt lika om man även inkluderar lösningsfrekvenser för delmomentet derivata (av kvot) och delmomentet räta linjens ekvation i analysen. Provresultaten för åren 1996–2013 har hämtats här och har för åren 2013–2022 erhållits direkt från biträdande professor Jana Madjarova, som är ansvarig för provet. Söktrycket har beräknats som antalet förstahandssökande/antalet nybörjare på civilingenjörsprogrammen, som rapporteras i Chalmers årsredovisningar sedan 1998. Ett förändrat söktryck kan alltså bero både på förändringar i antalet förstahandssökande och förändringar i antalet platser (eller en kombination av bägge). Resultaten är snarlika om man i stället beräknar söktrycket med UHR:s data över förstahandssökande och antagna till alla program på Chalmers. Dessa data finns tillgängliga från 1998. Se här för fler kommentarer kring de data som används.

- Dessa data har tagits fram och bearbetats av Hans Thunberg vid KTH. Söktrycket har även här beräknats som antalet förstahandssökande/antalet nybörjare.

artikel från Kvartal

- Alla artiklar

- Alla poddar

- Kvartals app

- Reklamfritt